Red Hat, el proveedor líder mundial de soluciones open source, presentó Red Hat AI 3, una importante evolución de su plataforma de IA para la empresa. Esta plataforma, que combina las últimas innovaciones de Red Hat AI Inference Server, Red Hat Enterprise Linux AI (RHEL AI) y Red Hat OpenShift AI, ayuda a simplificar las complejidades de la inferencia de IA de alto rendimiento a gran escala, lo cual permite a las organizaciones acelerar la transición de las cargas de trabajo de la prueba de concepto a producción, además de mejorar la colaboración en torno a aplicaciones basadas en IA.

A medida que las empresas trascienden la experimentación con la IA, se enfrentan a obstáculos significativos, entre ellos, la privacidad de los datos, el control de costos y la gestión de modelos dispares. El proyecto NANDA The GenAI Divide: State of AI in Business” del Massachusetts Institute of Technology, pone de relieve la realidad de la IA de producción, en la que cerca del 95 % de las organizaciones no están obteniendo retornos financieros cuantificables de los aproximadamente USD 40.000 millones que invierten las empresas.

Red Hat AI 3 se dedica a resolver directamente estos desafíos al ofrecer una experiencia más coherente y unificada para que los CIO y los responsables del área de TI maximicen sus inversiones en tecnologías de computación aceleradas. Red Hat AI 3 hace posible escalar y distribuir cargas de trabajo de IA con rapidez entre entornos híbridos de multiproveedores, a la vez que mejora la colaboración entre equipos en cargas de trabajo de IA de próxima generación como agentes, todo en la misma plataforma común. Gracias a que está diseñada sobre una base de estándares abiertos, Red Hat AI 3 asiste a las organizaciones en cualquier etapa en la que se encuentren en su experiencia con la IA, admitiendo cualquier modelo en cualquier acelerador de hardware, desde centros de datos, la nube pública y entornos de IA soberana hasta el edge más alejado.

Del entrenamiento a la “acción”: el cambio hacia la inferencia de IA empresarial

A medida que las organizaciones llevan las iniciativas de IA a la fase de producción, el foco pasa del entrenamiento y el ajuste de modelos a la inferencia, que sería la fase de “acción” de la IA empresarial. Red Hat AI 3 hace hincapié en la inferencia escalable y rentable al basarse en los proyectos comunitarios vLLM y llm-d de gran éxito, así como en las capacidades de optimización de modelos de Red Hat, y ofrece un servicio de modelos de lenguajes de gran tamaño (LLM) de nivel de producción.

Para ayudar a los CIO a sacar el máximo partido de su aceleración de hardware de alto valor, Red Hat OpenShift AI 3.0 presenta la disponibilidad general de llm-d, que reinventa la forma en que los LLM se ejecutan nativamente en Kubernetes. llm-d habilita la inferencia inteligente distribuida, que aprovecha el valor comprobado de la orquestación de Kubernetes y el rendimiento de vLLM, combinado con tecnologías open source clave como Kubernetes Gateway API Inference Extension, la librería de transferencia de baja latencia de NVIDIA Dynamo (NIXL) y la librería de comunicación DeepEP Mixture of Experts (MoE), permitiendo a las organizaciones:

- Reducir costos y mejorar los tiempos de respuesta, con la programación de modelos inteligente y consciente de la inferencia y el servicio desagregado;

- Ofrecer simplicidad operativa y máxima fiabilidad con ‘Rutas bien iluminadas’ prescriptivas que agilizan el despliegue de modelos a escala en Kubernetes.;

- Maximizar la flexibilidad con soporte multiplataforma para desplegar la inferencia de LLM en diferentes aceleradores de hardware, incluyendo NVIDIA y AMD.

llm-d parte de vLLM para evolucionar de un motor de inferencia de alto rendimiento en un solo nodo a un sistema de servicio uniforme, escalable y distribuido que permite un rendimiento predecible, un retorno de la inversión cuantificable y una planificación eficaz de la infraestructura. Todas las mejoras abordan directamente los desafíos que plantea el servicio de modelos masivos, como los modelos Mixture-of-Experts (MoE) y el manejo de cargas de trabajo muy variables.

Una plataforma unificada para la IA colaborativa

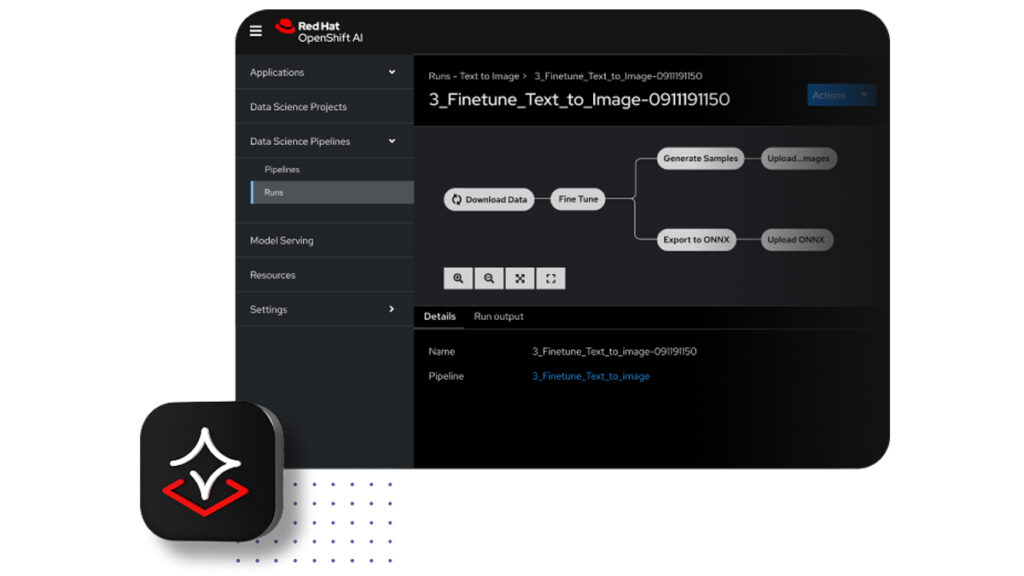

Red Hat AI 3 ofrece una experiencia unificada y flexible adaptada a las demandas de colaboración que exige la creación de soluciones de IA generativa listas para producción. Está diseñado para ofrecer valor tangible al fomentar la colaboración y unificar los flujos de trabajo entre equipos a través de una única plataforma para que tanto los ingenieros de plataforma como los ingenieros de IA ejecuten su estrategia de inteligencia artificial. Las nuevas capacidades enfocadas en proporcionar la productividad y eficiencia necesarias para escalar de la prueba de concepto a la producción incluyen:

- Capacidades de Modelo como Servicio (MaaS) se basan en la inferencia distribuida y permiten a los equipos de TI actuar como sus propios proveedores de MaaS, sirviendo modelos comunes de forma centralizada y proporcionando acceso bajo demanda tanto para los desarrolladores de IA como para las aplicaciones de IA. Esto permite una mejor gestión de costos y da soporte a casos de uso que no pueden ejecutarse en servicios públicos de IA debido a preocupaciones de privacidad o datos.

- AI hub permite a los ingenieros de plataforma explorar, desplegar y administrar activos fundamentales de IA. Proporciona un centro centralizado con un catálogo curado de modelos (incluidos modelos de IA generativa validados y optimizados), un registro para gestionar el ciclo de vida de los modelos y un entorno de despliegue para configurar y monitorizar todos los activos de IA que se ejecutan en OpenShift AI.

- Gen AI studio (Estudio de IA Generativa) ofrece un entorno práctico para que los ingenieros de IA interactúen con los modelos y prototipen rápidamente nuevas aplicaciones de IA generativa. Con la función de punto final de activos de IA (AI assets endpoint), los ingenieros pueden descubrir y consumir fácilmente los modelos disponibles y los servidores MCP (Model Control Plane), que están diseñados para agilizar la forma en que los modelos interactúan con herramientas externas. El playground integrado proporciona un entorno interactivo y sin estado para experimentar con modelos, probar prompts y ajustar parámetros para casos de uso como el chat y la generación aumentada por recuperación (RAG).

- Nuevos modelos de Red Hat validados y optimizados se incluyen para simplificar el desarrollo. La selección curada incluye modelos populares de código abierto como gpt-oss de OpenAI, DeepSeek-R1, y modelos especializados como Whisper para la conversión de voz a texto y Voxtral Mini para agentes habilitados por voz.

Sentando las bases para los agentes de IA de próxima generación

Los agentes de IA están destinados a transformar la forma en que se crean las aplicaciones y sus complejos flujos de trabajo autónomos impondrán grandes exigencias a las capacidades de inferencia. La versión Red Hat OpenShift AI 3.0 continúa sentando las bases para los sistemas de IA agénticos escalables, no solo a través de sus capacidades de inferencia, sino también al añadir nuevas características y mejoras enfocadas en la gestión de agentes.

Para acelerar la creación y la implementación de agentes, Red Hat ha introducido una capa de API unificadas basada en Llama Stack, que ayuda a alinear el desarrollo con estándares del sector como OpenAI compatibles con los protocolos de interfaces LLM. Asimismo, para promover un ecosistema más abierto e interoperable, Red Hat es pionero en la adopción de Model Context Protocol (MCP), un poderoso estándar emergente que simplifica la forma en que los modelos de IA interactúan con herramientas externas, lo que representa una característica fundamental para los agentes de IA modernos.

Red Hat AI 3 presenta un nuevo kit de herramientas modular y extensible para la personalización de modelos, desarrollado a partir de la funcionalidad existente de InstructLab. Este kit proporciona librerías especializadas de Python que otorgan a los desarrolladores mayor flexibilidad y control. El toolkit se basa en proyectos de código abierto como Docling para el procesamiento de datos, que agiliza la ingesta de documentos no estructurados a un formato que la IA puede leer. También incluye un marco de trabajo flexible para la generación de datos sintéticos y un centro de entrenamiento (training hub) para el ajuste fino de LLM.

El centro de evaluación (evaluation hub) integrado ayuda a los ingenieros de IA a monitorizar y validar los resultados, permitiéndoles aprovechar con confianza sus datos propietarios para obtener resultados de IA más precisos y relevantes.

Cita de apoyo

Joe Fernandes, vicepresidente y gerente general, Unidad de Negocio IA, Red Hat

‘A medida que las empresas pasan de la experimentación a producción de la IA, se enfrentan a una nueva serie de desafíos en términos de complejidad, costo y control. Con Red Hat AI 3, ofrecemos una plataforma open source de clase empresarial que minimiza estos obstáculos. Al incorporar nuevas capacidades, como la inferencia distribuida con llm-d y una base para la IA agéntica, hacemos posible que los equipos de TI pongan en marcha la IA de próxima generación con mayor confianza, según sus propios términos y en cualquier infraestructura’.